27M 파라미터가 7B 모델을 이겼다? HRM AI가 던지는 질문

솔직히 말해, ‘GPT를 뛰어넘는 AI 등장’ 같은 헤드라인에는 이제 무감각해질 때도 됐습니다. 대부분은 특정 작업에 유리한 벤치마크 결과를 부풀린 마케팅에 가깝습니다. 그래서 싱가포르 스타트업 Sapien AI가 공개한 HRM AI 소식을 처음 접했을 때도 습관적인 회의론부터 앞섰습니다. 하지만 공개된 데이터를 뜯어볼수록, 이번엔 이야기가 좀 다르다는 것을 인정할 수밖에 없었습니다.

이 모델은 단순히 더 많은 데이터로 학습하거나 기존 모델을 경량화한 것이 아닙니다. 아예 다른 방식으로 설계된 AI 추론 모델이었고, 그 결과는 꽤 인상적이었습니다.

3줄 요약:

1. 2,700만(27M) 파라미터의 소형 모델 HRM이 스도쿠, 미로 찾기 등 복잡한 추론 벤치마크에서 250배 이상 큰 거대 언어 모델(LLM)을 압도했습니다.

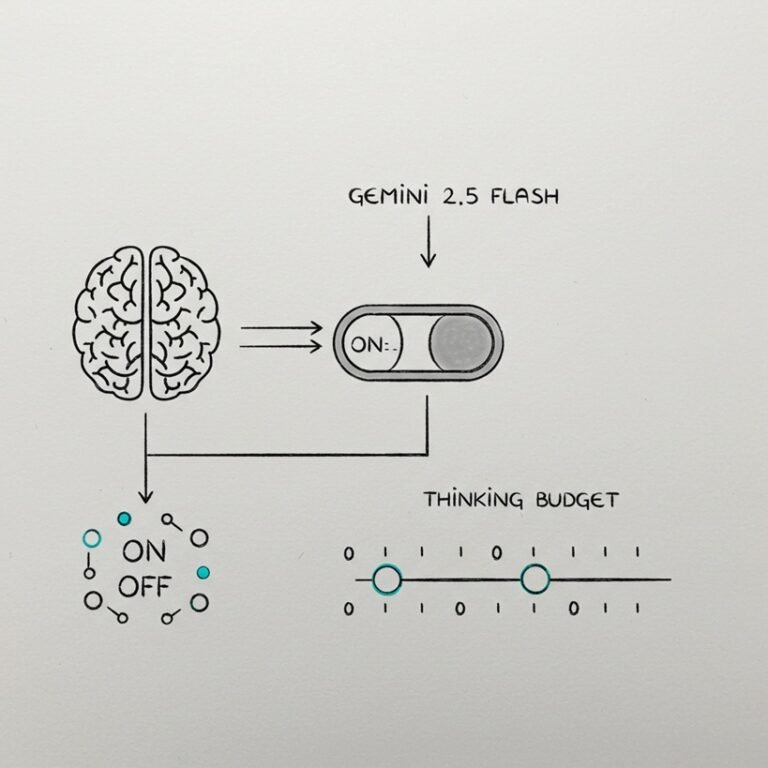

2. 이는 기존 트랜스포머의 ‘연쇄 사고(Chain-of-Thought)’가 아닌, 인간의 뇌처럼 ‘계획-실행-검토’를 반복하는 계층적 순환(Hierarchical Recurrent) 아키텍처 덕분입니다.

3. HRM은 특정 작업에서 압도적 성능과 훈련 효율성을 보여주며, AI 발전의 다음 단계가 ‘크기’가 아닌 ‘구조’의 혁신일 수 있음을 증명합니다.

HRM AI: ‘더 크게’가 아닌 ‘다르게’ 생각하는 구조

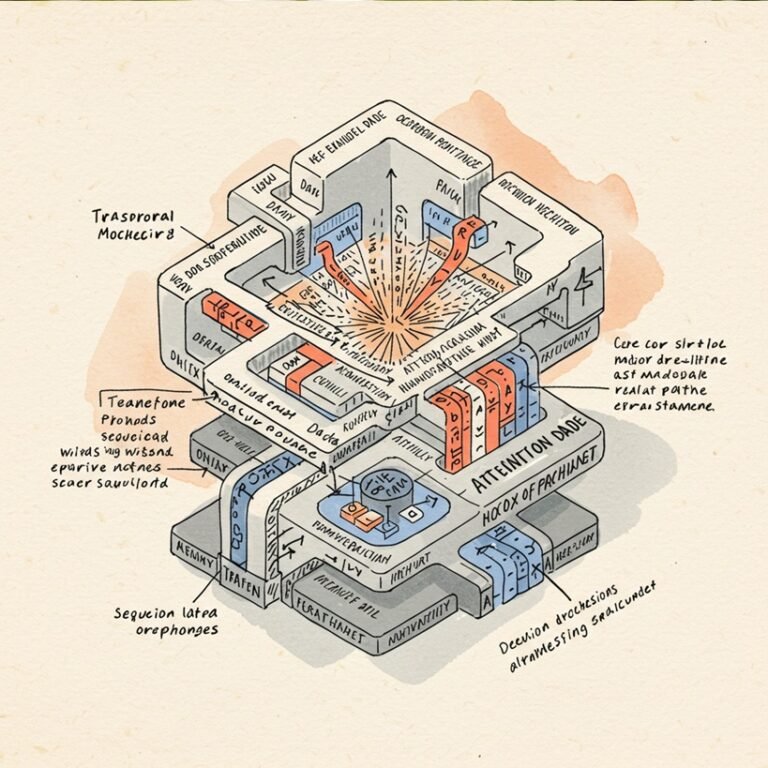

제가 주목한 지점은 크기가 아니었습니다. GPT-1(117M)의 4분의 1도 안 되는 27M 파라미터라는 점은 흥미롭지만, 핵심은 아니었죠. 중요한 것은 ‘어떻게’ 이런 결과를 만들었는가입니다. HRM은 계층적 순환 모델(Hierarchical Recurrent Model)의 약자로, 이름처럼 두 개의 계층이 서로 대화하며 문제를 풉니다.

▪ 상위 모듈 (Planner): 느리지만 전략적으로 사고합니다. 문제의 큰 그림을 보고 어떤 접근법이 필요한지 계획을 세웁니다. 체스 마스터가 전체 판을 읽고 전략을 구상하는 것과 비슷합니다.

▪ 하위 모듈 (Worker): 빠르고 효율적으로 실행합니다. 상위 모듈의 지시를 받아 실제 연산을 신속하게 처리하고 결과를 보고합니다.

이 두 모듈은 정답에 도달할 때까지 계획, 실행, 피드백의 순환 고리(Loop)를 반복합니다. 문제를 풀다가 중간에 자신의 추론 과정을 스스로 점검하고 수정하는 셈입니다. 이는 한번 생성된 토큰을 수정할 수 없는 단방향성(autoregressive)을 가진 기존 트랜스포머 모델과는 구조적으로 다른 접근입니다.

데이터로 증명된 AI 추론 능력 벤치마크

스도쿠 55% vs 0%, 단순 비교를 넘어선 격차

그럴싸한 개념처럼 들릴지 모르지만, 벤치마크 결과는 이 구조적 차이가 실제 성능에 어떤 영향을 미치는지 명확히 보여줍니다.

▪ ARC-AGI (AI 지능 지수 테스트): HRM(27M)은 40.3%를 기록, Mistral-7B(35.1%)를 앞섰습니다.

▪ 스도쿠 (어려움/극악 난이도): HRM(27M)은 55%의 해결률을 보였습니다. 비교 대상인 Mistral-7B, Gemini 1.0 Pro의 성적은? 0%였습니다. 단 한 문제도 풀지 못했습니다.

▪ 30×30 미로 찾기: HRM(27M)은 74.5%의 테스트에서 최적 경로를 찾아냈습니다. 다른 모델들은 역시 0%였습니다.

| 벤치마크 | HRM (27M) | Mistral-7B (7B) | Gemini 1.0 Pro (100B+) |

| ARC-AGI | 40.3% | 35.1% | 35.7% |

| 스도쿠 (Hard/Extreme) | 55.0% | 0% | 0% |

| 미로 찾기 (30×30) | 74.5% | 0% | 0% |

이 결과는 작은 모델이 특정 조건에서 조금 더 나은 성능을 보인 수준이 아닙니다. 파라미터가 250배 이상 차이 나는 모델들이 손도 대지 못하는 특정 ‘추론’ 영역에서, 아예 다른 체급의 선수처럼 움직인다는 이야기입니다.

기존 트랜스포머 아키텍처의 한계

‘외통수’에 갇힌 연쇄 사고와 고정된 연산량

왜 이런 차이가 발생할까요? 현재 대부분의 LLM이 의존하는 ‘연쇄 사고(Chain-of-Thought)’ 방식의 한계 때문입니다. 단계별로 문제를 풀어나가는 방식은 그럴듯해 보이지만, 치명적인 약점이 있습니다. 첫 단추를 잘못 꿰면, 즉 연쇄 고리 중 하나라도 오류가 발생하면 전체 답변이 무너집니다. 한 번 쓴 숫자는 절대 지울 수 없는 펜으로 수학 문제를 푸는 셈입니다.

또한 트랜스포머는 문제의 난이도와 상관없이 토큰 하나를 생성하는 데 거의 고정된 연산량을 사용합니다. 쉬운 질문이나 어려운 질문이나 똑같은 노력을 들이는 셈이죠.

반면 HRM은 문제의 난이도에 따라 생각하는 시간을 조절하는 적응형 연산(adaptive computation)을 사용합니다. 간단한 문제는 몇 번의 루프만으로 해결하고, 복잡한 문제는 더 많은 루프를 돌며 정답에 근접합니다. 훨씬 유연하고 인간의 사고방식에 가깝습니다.

훈련 효율성: 2 GPU 시간, 이것이 시사하는 바

더 놀라운 것은 훈련 방식입니다. HRM은 각 태스크당 단 1,000개의 예제로 훈련되었습니다. 인터넷 전체를 긁어모은 방대한 데이터셋도, 몇 달씩 걸리는 사전 훈련도 없었습니다. 개발자에 따르면 스도쿠 프로 레벨까지 훈련하는 데 단 2 GPU 시간이면 충분했다고 합니다.

이는 단순히 비용 효율적인 것을 넘어, AI 모델의 스케일업 방향성에 중요한 질문을 던집니다. 막대한 자원 없이도 특정 영역에서 월등한 성능을 내는 AI 아키텍처가 가능하다는 실증적 사례이기 때문입니다.

새로운 가능성: 크기를 넘어 아키텍처로

아직은 ‘추론 전문’, 그러나 중요한 방향 제시

물론 HRM이 만능은 아닙니다. 이 모델은 시를 쓰거나 이메일을 요약하는 일반적인 언어 능력에서는 LLM을 따라가지 못합니다. 철저히 ‘추론’을 위해 설계된 특수 목적 모델에 가깝습니다.

정작 중요한 것은 방향성입니다. AI의 발전이 무조건 더 큰 데이터센터와 더 많은 GPU를 요구하는 방향으로만 흐르지 않을 수 있다는 가능성을 보여줬습니다. 이 프로젝트가 HRM AI 깃허브에 전부 오픈소스로 공개되었다는 점은, 이러한 접근법에 대한 기술적 검증을 자신한다는 의미로 읽힙니다.

개인적으로 다음 세대의 AI 추론 모델 경쟁은 단순히 파라미터 숫자를 늘리는 싸움이 아닐 것이라 봅니다. HRM처럼 더 효율적이고, 더 논리적인 구조를 설계하는 아키텍처 레벨의 경쟁이 본격화될 것입니다. 그리고 그 경쟁은 데이터센터가 아닌, 우리 노트북 안에서 벌어질지도 모릅니다.

자주 묻는 질문 (FAQ)

HRM AI는 무엇이며, 기존 LLM과 어떤 차이가 있나요?

HRM AI(Hierarchical Recurrent Model)는 Sapien AI가 개발한 2,700만 파라미터의 소형 AI 추론 모델입니다. 기존 LLM이 단방향 연쇄 사고(Chain-of-Thought) 방식을 사용하는 것과 달리, HRM은 ‘계획-실행-검토’를 반복하는 계층적 순환 아키텍처를 통해 문제를 해결합니다.

HRM AI가 복잡한 추론 문제에서 LLM을 압도하는 비결은 무엇인가요?

HRM AI는 상위 모듈(Planner)과 하위 모듈(Worker)이 협력하여 문제를 해결하는 계층적 순환 구조 덕분입니다. 이 구조는 정답에 도달할 때까지 추론 과정을 스스로 점검하고 수정하며, 문제 난이도에 따라 연산량을 조절하는 적응형 연산을 사용하기 때문에 복잡한 추론에서 뛰어난 성능을 보입니다.

기존 트랜스포머 아키텍처의 주요 한계점은 무엇인가요?

기존 트랜스포머 아키텍처는 ‘연쇄 사고’ 방식의 한계로 인해, 추론 과정 중 한 번의 오류가 전체 답변을 무너뜨릴 수 있습니다. 또한, 문제 난이도와 상관없이 고정된 연산량을 사용하므로 비효율적이며, 생성된 토큰을 수정할 수 없는 단방향성으로 인해 복잡한 추론에 취약합니다.

HRM AI의 훈련 효율성이 시사하는 바는 무엇인가요?

HRM AI는 각 태스크당 단 1,000개의 예제로 훈련되었고, 스도쿠 프로 레벨 훈련에 단 2 GPU 시간만 소요되었습니다. 이는 막대한 자원 없이도 특정 영역에서 월등한 성능을 내는 AI 아키텍처가 가능함을 보여주며, AI 모델 스케일업 방향성에 중요한 질문을 던집니다.

HRM AI가 AI 발전의 다음 단계에 어떤 영향을 미칠까요?

HRM AI는 AI 발전이 무조건적인 ‘크기’ 확장이 아닌, ‘구조’와 ‘아키텍처’ 혁신으로 나아갈 수 있음을 시사합니다. 이는 더 효율적이고 논리적인 AI 추론 모델 개발 경쟁을 촉발할 것이며, 미래 AI가 더 적은 자원으로도 특정 분야에서 강력한 성능을 발휘할 수 있음을 보여줍니다.