Last Updated on 2025-08-08 by AEIAI.NET

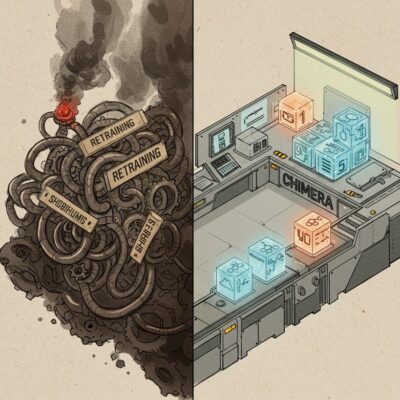

AI 모델 병합, 재학습은 이제 그만. DeepSeek Chimera가 보여준 충격적인 효율

API 호출 비용, 그리고 답답한 응답 속도. 아마 소규모 AI 서비스를 운영하는 개발자라면 누구나 매일같이 청구서와 씨름하고 계실 겁니다. 새로운 모델이 나올 때마다 ‘이번엔 좀 다르겠지’ 기대하지만, 막상 적용해보면 비용과 속도, 둘 중 하나는 반드시 우리의 발목을 잡죠. 그렇다고 밑 빠진 독에 물 붓는 심정으로 비싼 GPU를 돌려 파인튜닝을 할 수도 없는 노릇입니다.

저 역시 이런 고민의 한가운데서 ‘DeepSeek Chimera’라는 이름을 처음 들었습니다. 재학습(retraining) 하나 없이, 기존 모델 여러 개를 합쳐서 더 빠르고, 똑똑하고, 저렴한 모델을 만들었다는 주장. 솔직히 말해 처음엔 믿지 않았습니다. 전형적인 학계의 뜬구름 잡는 소리, 그 이상도 이하도 아닐 거라 생각했죠. 하지만 직접 파고들어 보니, 이건 단순한 연구가 아니라 LLM 개발의 판도를 바꿀 ‘사건’에 가까웠습니다.

핵심만 콕 집어보면?

1. 재학습은 이제 안녕: ‘Assembly of Experts(AoE)’라는 기술로, 기존 모델들의 가장 뛰어난 부분(가중치)만 골라 산술적으로 ‘조립’합니다. GPU를 몇 주씩 태우는 끔찍한 재학습 과정이 통째로 사라집니다.

2. 성능과 속도, 미친 가성비: 이 방식으로 태어난 DeepSeek Chimera는 추론 능력은 그대로인데, 응답 속도는 2배 빨라지고 답변은 간결해져 토큰 비용까지 아껴줍니다.

3. 새로운 시대의 개막: 더 이상 비싼 돈 들여 모델을 만들거나 튜닝할 필요가 없습니다. 검증된 오픈소스 모델들을 ‘레고’처럼 조립해 내 입맛에 맞는 최적의 모델을 직접 만들 수 있는 시대가 열렸습니다.

AI 모델 병합, ‘조립’이라는 새로운 패러다임 (Assembly of Experts)

대부분의 LLM 개선 작업은, 솔직히 말해 고통 그 자체입니다. 새로운 데이터를 긁어모으고, 클라우드 GPU를 몇 주간 태우며 재학습을 돌리고, 제발 결과물이 과적합되거나 헛소리를 하지 않기를 기도하는 과정의 반복이죠. 하지만 AoE, 즉 ‘전문가 조립’ 방식은 이 모든 끔찍한 과정을 시원하게 건너뜁니다.

훈련은 그만, 똑똑한 뇌를 ‘복사-붙여넣기’

자, 한번 상상해보세요. 모델의 뇌 속에는 수천억 개의 미세한 다이얼(가중치 텐서)이 있습니다. AoE는 이 다이얼을 처음부터 다시 맞추는 고생 대신, 이미 성능이 검증된 여러 모델(부모 모델)의 다이얼 설정값을 그냥 가져옵니다. 그리고 각 모델의 장점만 콕 집어 말 그대로 ‘평균’을 내거나 특정 비율로 섞어버리는 거죠.

이건 경사 하강법(gradient descent)을 통해 최적점을 찾아가는 고통스러운 등산이 아닙니다. 순수한 텐서 대수학(tensor algebra)을 이용한 산술 연산, 거의 계산기에 가깝습니다. 덕분에 괜찮은 워크스테이션만 있다면 커피 한 잔 마시는 동안 모델 병합이 끝납니다. 이것이 바로 AI 모델 병합 기술이 혁신적인 이유입니다. GPU를 태우며 몇 주를 기다릴 필요가 전혀 없다는 뜻이니까요.

DeepSeek Chimera 성능, 정말 쓸만할까? (벤치마크 파헤치기)

“그렇게 쉽게 합친 모델이 제대로 작동할 리가 없잖아.” 네, 저 역시 똑같이 생각했습니다. 속도를 얻는 대신 지능을 잃는, 전형적인 ‘조삼모사’일 것이라 의심했죠. 그래서 공개된 벤치마크 결과를 의심의 눈초리로 집요하게 뜯어봤습니다.

“빠르지만 멍청하겠지” 제 편견이 깨졌습니다

결과는 제 예상을 완전히 빗나갔습니다. MT-Bench, GPQA diamond 같은 주요 벤치마크에서 Chimera 모델은 부모 모델과 거의 동급의 점수를 기록했습니다. 특히 수학 문제 해결 능력을 테스트하는 AIME 벤치마크에서는 원본 R1 모델과 대등하거나, 심지어 일부 앞서는 결과까지 보여주더군요.

이건 단순한 점수놀음이 아닙니다. 추론 능력의 핵심은 그대로 유지하면서, 응답 길이를 대폭 줄여 속도와 비용 효율성을 극대화했다는 구체적인 증거입니다. 더 이상 장황한 곁가지 설명 없이, 핵심적인 계산 과정만 명료하게 보여주니 개발자 입장에선 속이 다 시원합니다.

R1의 ‘깊은 뇌’와 V3의 ‘날렵한 입’을 합친 결과

이 마법 같은 결과의 비밀은 바로 ‘선택과 집중’에 있었습니다. 개발팀은 DeepSeek-Coder-V2의 간결한 답변 생성 능력(Attention/Shared Layer)과 DeepSeek-LLM-67B-Chat(R1)의 깊은 추론 능력(Routed Expert Layer)을 정확히 분리해냈습니다.

더 쉽게 말해볼까요? R1의 똑똑하고 깊은 ‘뇌’는 그대로 두고, V3의 간결하고 빠른 ‘입’을 가져와 붙인 셈입니다. 그 결과, 생각은 R1처럼 깊게 하지만 표현은 V3처럼 간결하게 하는, 꿈에 그리던 모델이 탄생한 겁니다. 답변이 짧아지니 GPU 처리 시간이 줄고, 사용하는 토큰 수가 감소하니 API 비용도 자연스레 절감됩니다. 제가 매일같이 씨름하던 두 가지 문제를 동시에 해결한, 그야말로 유레카의 순간이었습니다.

LLM 추론 비용 절감을 위한 실용적 가이드

이쯤 되면 궁금해집니다. “그래서, 이걸로 내 문제를 어떻게 해결할 수 있는데?” 맞습니다. 이 Assembly of Experts 기술은 단순한 연구실의 장난감이 아닙니다. 당장 우리 현업에 적용할 수 있는 구체적인 가치를 던져줍니다.

실패 없는 실험실, ‘파라미터 밸리’라는 안전지대

더 흥미로운 지점은 모델을 섞는 과정에서 발견된 ‘임계점’입니다. R1 모델의 비중을 54.4%로 높이는 바로 그 순간, 이전까지 나타나지 않던 “ 태그가 갑자기 모든 답변에 나타나기 시작했습니다. 특정 행동이 모델 가중치의 아주 정밀한 특정 지점에 박혀있다는 소름 돋는 증거죠.

이는 AoE가 단순히 모델을 뭉뚱그리는 것이 아니라, 원하는 특성만 정밀하게 켜고 끌 수 있는 ‘스위치’ 역할을 할 수 있음을 보여줍니다. 또한, 대부분의 조합이 깨지지 않고 쓸만한 결과물을 내놓는 ‘파라미터 밸리’ 현상은 이 AI 모델 병합 방식이 매우 안정적이고 탐색하기 쉬운 ‘안전지대’임을 증명합니다. 즉, 실패의 위험 부담 없이 다양한 조합을 시도하며 내 서비스에 딱 맞는 최적의 모델을 찾아낼 수 있다는 의미입니다.

그래서, 이걸로 뭘 할 수 있냐고요?

- 숨통 트이는 비용 절감: DeepSeek Chimera의 경우, 답변에 필요한 토큰 수가 40% 가까이 줄어듭니다. 하루 50억 개 토큰을 처리하는 서비스라면, 그 절감 효과는 상상을 초월하겠죠.

- 기다림 없는 실시간 응답: 기존 모델보다 2배 빠른 속도는 채팅 어시스턴트나 실시간 번역 같은 서비스에서 ‘답답함’과 ‘쾌적함’의 차이를 만듭니다.

- 믿음을 주는 투명성: 금융, 의료, 법률 분야처럼 논리적 근거 제시가 필수적인가요? AI 모델 병합으로 탄생한 Chimera는 장황한 부연 설명 없이 명확한 사고 과정(Chain-of-Thought)을 보여줘 신뢰도를 높여줍니다.

- 자유로운 상업적 활용: MIT 라이선스로 공개되어 있어, 법적 문제 없이 내 서비스 백엔드에 바로 붙여 마음껏 돈을 벌 수 있습니다.

| 항목 | 전통적인 파인튜닝 (Fine-tuning) | 전문가 조립 (Assembly of Experts) |

|---|---|---|

| 비용 | 극도로 높음 (GPU 클러스터, 전기료 폭탄) | 매우 낮음 (내 워크스테이션으로도 충분) |

| 시간 | 수일 ~ 수주 (기다리다 지침) | 수 분 ~ 수 시간 (커피 한 잔의 여유) |

| 하드웨어 | 고사양 GPU 클러스터 필수 | 상대적으로 낮은 사양으로도 가능 |

| 유연성 | 데이터셋에 종속, 과적합 위험 | 다양한 모델의 장점만 쏙쏙 조합 가능 |

| 핵심 원리 | 경사 하강법 기반의 고통스러운 재학습 | 텐서 대수학 기반의 우아한 가중치 병합 |

결론은 명확합니다. 수천억을 들여 만든 모델의 지식을 버리고 처음부터 다시 훈련하는 것은 이제 비효율의 극치입니다. Assembly of Experts와 같은 AI 모델 병합 기술은 기존의 막대한 투자를 재활용하면서, 더 빠르고 저렴하게 모델을 개선할 수 있는 가장 합리적인 대안입니다.

기다리지 말고, 직접 ‘조립’하라

DeepSeek Chimera는 그저 ‘잘 나온 모델’이 아닙니다. 이것은 LLM 시장의 게임의 룰을 바꾸는 선언과 같습니다. 이제 우리는 거대 기업이 다음 모델을 출시해주기만을 목 빠지게 기다릴 필요가 없습니다. 이미 검증된 수많은 오픈소스 모델들이 우리 손안에 있으니까요.

코딩 능력, 추론 능력, 특정 언어 구사 능력 등 각기 다른 강점을 가진 모델들의 ‘전문가 레이어’를 꺼내와 내 필요에 맞게 조립하면 그만입니다. AI 모델 병합은 더 이상 연구자들의 전유물이 아닙니다. 비용과 속도 문제로 밤잠 설치는 모든 개발자와 기업에게 주어진 새로운 무기입니다. 이제 남의 손에 맡기지 말고, 직접 최적의 모델을 ‘조립’해볼 차례입니다.

AoE는 여러 개의 이미 훈련된 언어 모델을 재학습 없이 합치는 기술입니다. 각 모델의 뇌세포 격인 가중치 텐서를 직접 가져와, 특정 기능(추론, 문장 생성 등)을 담당하는 부분끼리 평균을 내거나 특정 비율로 섞어 새로운 단일 모델을 만드는 방식이죠. 복잡한 훈련 과정이 없어 시간과 비용을 획기적으로 줄일 수 있는, 말 그대로 ‘가성비’ 끝판왕 기술입니다.

아쉽지만, 그렇지는 않습니다. 현재 AoE 기법이 가장 효과적으로 작동하려면, 합치려는 모델들이 동일한 아키텍처(뼈대 구조), 예를 들어 동일한 MoE(Mixture of Experts) 구조를 공유해야 합니다. DeepSeek 모델들이나, 향후 나올 Gemini, Qwen 계열의 MoE 모델들이 좋은 대상이 될 수 있죠. 뼈대 자체가 다른 모델을 억지로 합치면 성능을 보장하기 어렵습니다.

정답은 ‘목적에 따라 다르다’입니다. 기존 모델들의 장점을 결합해 전반적인 성능(속도, 비용, 추론 능력)을 빠르게 개선하고 싶다면 AI 모델 병합이 압도적으로 유리합니다. 하지만 아주 특수한 분야, 예를 들어 우리 회사 내부 문서에 대한 지식을 콕 집어 주입해야 한다면, 여전히 해당 데이터로 파인튜닝하는 것이 더 효과적일 수 있습니다.

수 주간의 GPU 훈련이 필요한 파인튜닝과 달리, AoE는 모델의 가중치 파일을 불러와 숫자 계산을 하는 것이 전부입니다. 따라서 모델 파일을 저장할 충분한 저장 공간(SSD)과 메모리(RAM)를 갖춘 괜찮은 성능의 워크스테이션만으로도 충분히 시도해 볼 수 있습니다. Nvidia H100이나 AMD Mi300 같은 최고 사양의 GPU가 꼭 필요한 건 아닙니다.