파인튜닝이란? AI 모델 성능 극대화 비법 (뜻, 방법, 사례)

파인튜닝(Fine-tuning) 뜻이 궁금하신가요? 사전 훈련된 AI 모델을 특정 작업에 맞게 최적화하는 파인튜닝의 의미, 원리, 장점, 활용 사례를 쉽게 설명합니다.

ChatGPT 같은 AI, 우리 회사 서비스에 딱 맞게 쓸 순 없을까?

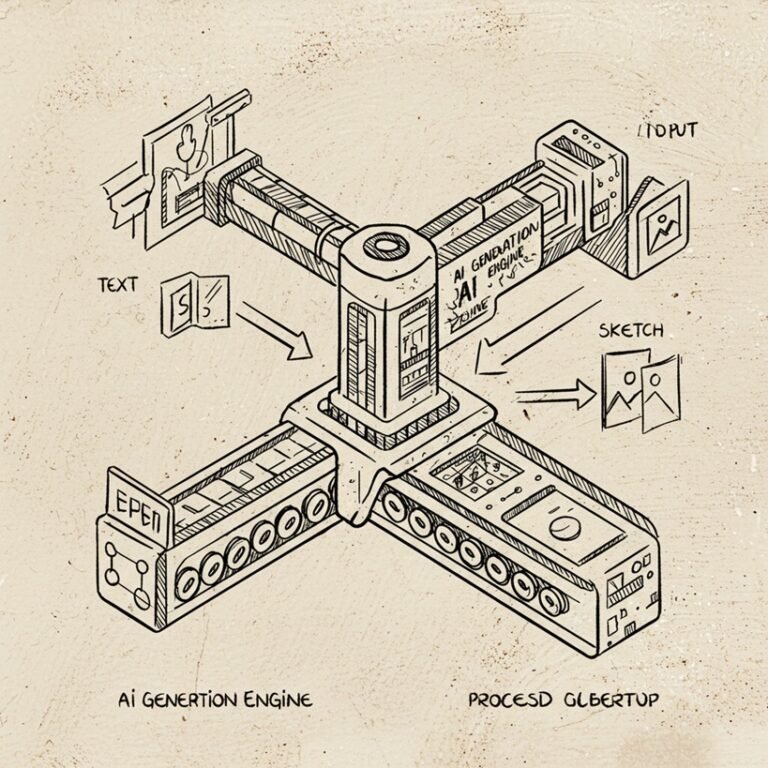

요즘 GPT, BERT 같은 강력한 사전 훈련 모델(Pre-trained Model) 덕분에 AI 기술이 놀라운 발전을 이루고 있습니다. 하지만 이런 범용 모델들은 때때로 우리가 원하는 특정 작업이나 특정 도메인의 미묘한 맥락까지 완벽하게 이해하지는 못할 때가 있죠. 마치 기성복 정장이 누구에게나 어느 정도 맞지만, 완벽한 핏을 위해서는 개인에게 맞게 수선하는 과정이 필요한 것처럼요.

바로 이 ‘맞춤 수선’ 과정에 해당하는 것이 AI 세계의 파인튜닝(Fine-tuning) 입니다. 파인튜닝은 이미 방대한 데이터로 똑똑하게 훈련된 모델을 가져와서, 우리가 정말로 필요로 하는 특정 작업이나 데이터에 맞게 살짝 더 훈련시켜 성능을 극대화하는 기술입니다.

이 글에서는 파인튜닝이 정확히 무엇인지, 왜 중요한지, 어떻게 작동하는지 그 핵심 원리를 파헤치고, 다른 AI 학습 방법들과는 무엇이 다른지 명확하게 비교해 드릴 것입니다. 더 나아가 실제 활용 사례와 장단점까지 살펴보며, 파인튜닝이라는 강력한 도구를 언제 어떻게 활용해야 할지에 대한 실질적인 통찰력을 얻어 가실 수 있도록 돕겠습니다.

파인튜닝, 정확히 무엇인가요? 핵심 개념과 쉬운 비유

파인튜닝(Fine-tuning) 은 말 그대로 ‘미세 조정’을 의미합니다. AI 분야에서는, 이미 대규모 데이터셋으로 학습된 사전 훈련 모델(Pre-trained Model)을 특정 하위 작업(Downstream Task)이나 특정 도메인의 데이터에 맞게 추가적으로 학습시켜 모델의 성능을 개선하고 최적화하는 과정을 말합니다.

핵심은 ‘처음부터 만드는 것이 아니라, 이미 잘 만들어진 것을 기반으로 약간 수정하여 더 좋게 만든다’ 는 것입니다.

- 쉬운 비유 1: 맞춤 정장 수선

- 사전 훈련 모델 = 잘 만들어진 기성복 정장 (일반적인 체형에 잘 맞음)

- 파인튜닝 = 내 몸에 맞게 소매 길이, 허리 라인 등을 수선하는 과정

- 결과 = 나에게 완벽하게 맞는 맞춤 정장 (특정 작업에 최적화된 모델)

- 쉬운 비유 2: 전문의가 되는 일반의

- 사전 훈련 모델 = 다양한 의학 지식을 갖춘 일반의

- 파인튜닝 = 특정 분야(심장내과, 피부과 등)에 대한 심화 학습 및 임상 경험

- 결과 = 특정 질환 진단 및 치료에 뛰어난 전문의 (특정 작업 수행 능력이 뛰어난 모델)

이처럼 파인튜닝은 범용적인 능력을 갖춘 모델에게 특정 분야의 전문성을 부여하는 과정이라고 이해할 수 있습니다. 이는 전이 학습(Transfer Learning) 이라는 더 큰 개념의 일부로, 한 분야에서 학습된 지식(가중치)을 다른 관련 분야나 작업에 활용하는 기법입니다.

왜 사전 훈련된 모델을 ‘파인튜닝’ 할까요? 등장 배경과 핵심 가치

AI 모델을 처음부터 학습시키는 것(Pre-training)은 엄청난 양의 데이터와 막대한 컴퓨팅 자원, 그리고 긴 시간이 필요합니다. 구글, OpenAI 같은 빅테크 기업들이 수백만, 수십억 개의 파라미터를 가진 거대 언어 모델(LLM) 등을 개발할 수 있는 이유죠.

하지만 대부분의 기업이나 개인 개발자들은 이런 규모의 자원을 확보하기 어렵습니다. 또한, 특정 작업(예: 특정 산업 분야의 고객 문의 응대, 의료 영상 판독 보조)에는 범용 모델보다 해당 분야에 특화된 모델이 더 높은 성능을 발휘합니다.

이러한 배경에서 파인튜닝의 핵심 가치가 드러납니다.

- 효율성 (시간, 비용, 데이터 절약): 처음부터 모델을 학습시키는 대신, 이미 잘 학습된 모델을 활용하므로 훨씬 적은 데이터와 컴퓨팅 자원으로 빠르게 원하는 성능을 달성할 수 있습니다.

- 성능 향상: 범용 모델이 갖춘 광범위한 지식을 바탕으로 특정 작업에 필요한 미묘한 패턴이나 특징을 추가 학습하여, 해당 작업에서의 정확도와 성능을 크게 높일 수 있습니다.

- 거대 모델 활용: 개인이 직접 만들기 어려운 거대 모델의 강력한 능력을 특정 문제 해결에 효과적으로 활용할 수 있게 해줍니다.

파인튜닝 개념은 특히 컴퓨터 비전 분야에서 이미지 분류 모델(예: ImageNet으로 사전 훈련된 모델)을 특정 객체 탐지 작업에 적용하면서 널리 사용되기 시작했고, 이후 자연어 처리(NLP) 분야에서 BERT와 같은 사전 훈련 언어 모델이 등장하면서 더욱 중요성이 부각되었습니다. BERT 논문은 다양한 NLP 하위 작업에 파인튜닝을 적용하여 뛰어난 성능을 달성할 수 있음을 보여주었습니다.

핵심 원리 파헤치기: 파인튜닝은 어떻게 작동할까?

파인튜닝의 과정은 다음과 같이 요약할 수 있습니다.

- 사전 훈련 모델 준비: 해결하려는 작업과 관련된 대규모 데이터셋으로 미리 학습된 모델(예: BERT, GPT, ResNet 등)을 선택합니다. 이 모델은 이미 기본적인 언어 이해 능력이나 이미지 특징 추출 능력 등을 갖추고 있습니다.

- 특정 작업 데이터셋 준비: 파인튜닝의 목표가 되는 특정 작업(예: 영화 리뷰 감성 분석, 의료 이미지 분류)에 맞는 레이블링된 소규모 데이터셋을 준비합니다. 이 데이터는 모델이 새롭게 배워야 할 특정 지식이나 패턴을 담고 있습니다.

- 모델 구조 수정 (선택 사항): 사전 훈련 모델의 마지막 레이어(출력 레이어)를 특정 작업의 출력 형식에 맞게 수정하거나 교체합니다. 예를 들어, 언어 모델을 이진 분류(긍정/부정) 작업에 사용하려면 출력 레이어를 두 개의 뉴런으로 변경해야 할 수 있습니다.

- 추가 학습 (Further Training): 준비된 특정 작업 데이터셋을 사용하여 사전 훈련 모델을 추가적으로 학습시킵니다. 이때 학습률(Learning Rate)은 사전 훈련 때보다 일반적으로 훨씬 작게 설정하여, 기존에 학습된 좋은 가중치들을 크게 해치지 않으면서 새로운 작업에 맞게 미세하게 조정합니다.

- 가중치 업데이트: 추가 학습 과정에서 모델의 가중치(파라미터)들이 새로운 데이터셋에 맞게 조금씩 업데이트됩니다. 모델의 모든 레이어 가중치를 업데이트할 수도 있고(Full Fine-tuning), 성능과 효율성을 고려하여 일부 레이어(주로 마지막 레이어들)만 업데이트하거나, 특정 파라미터만 효율적으로 업데이트하는 기법(PEFT 등)을 사용할 수도 있습니다.

- 성능 평가: 파인튜닝된 모델의 성능을 평가 데이터셋으로 측정하고, 목표 성능에 도달했는지 확인합니다.

이 과정을 통해 사전 훈련 모델은 기존의 범용적인 지식은 유지하면서, 새로운 특정 작업에 대한 전문성을 갖추게 되는 것입니다.

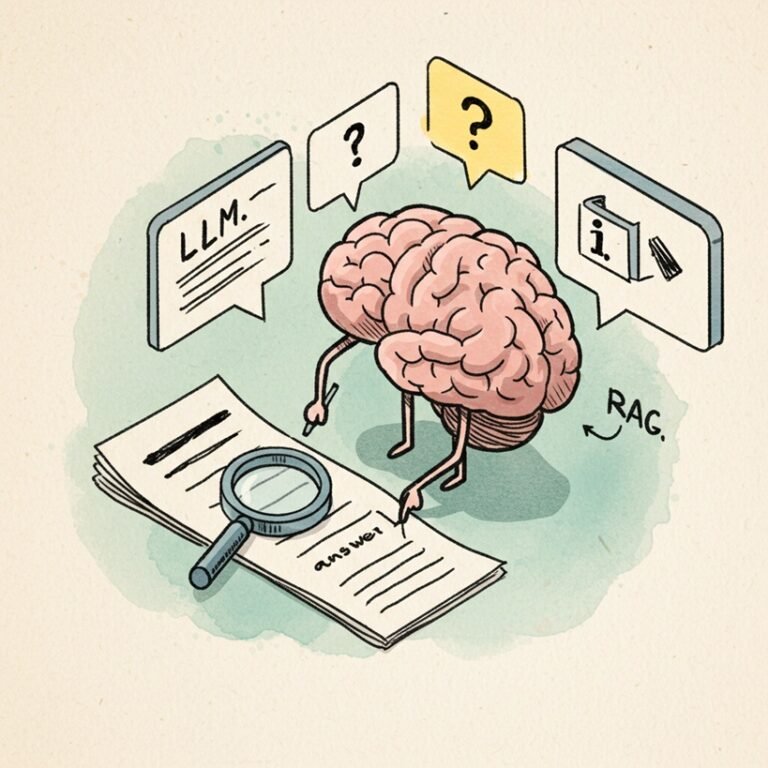

파인튜닝 vs 사전 훈련 vs 프롬프트 엔지니어링 vs RAG: 무엇이 다르고 언제 쓸까?

AI 모델을 활용하는 방식은 파인튜닝 외에도 여러 가지가 있습니다. 각 방식의 차이를 이해하는 것은 중요합니다.

| 구분 | 사전 훈련 (Pre-training) | 파인튜닝 (Fine-tuning) | 프롬프트 엔지니어링 (Prompt Eng.) | RAG (Retrieval-Augmented Gen.) |

| 주요 목표 | 범용적인 지식/능력 학습 (기초 모델 구축) | 특정 작업/도메인 성능 최적화 | 모델 수정 없이 입력(프롬프트)으로 제어 | 외부 지식 검색하여 답변 생성 보강 |

| 필요 데이터 | 대규모, 레이블 없는 데이터 가능 | 소규모, 특정 작업 관련 레이블된 데이터 | 예시 프롬프트 (Few-shot) 외 불필요 | 외부 지식 데이터베이스 (Vector DB 등) |

| 모델 가중치 수정 | 수정됨 (처음부터 학습) | 수정됨 (미세 조정) | 수정 안 됨 | 수정 안 됨 |

| 주요 장점 | 강력한 범용 성능 | 특정 작업 고성능, 효율성 | 간편함, 빠른 적용, 비용 효율 | 최신/외부 정보 반영, 환각 감소 |

| 주요 단점 | 막대한 자원/시간 필요 | 데이터 필요, 재앙적 망각 가능성, 비용 발생 | 성능 한계, 프롬프트 의존성 높음 | 검색 성능 의존, 시스템 복잡성 증가 |

| 언제 사용 할까? | 새로운 기초 모델 개발 시 | 특정 작업 성능 극대화 필요 시 | 간단한 작업, 빠른 프로토타이핑 시 | 최신 정보나 특정 문서 기반 답변 필요 시 |

간단히 말해:

- 사전 훈련: 똑똑한 ‘일반의’ 만들기

- 파인튜닝: ‘일반의’를 특정 분야 ‘전문의’로 만들기 (모델 자체를 수정)

- 프롬프트 엔지니어링: ‘일반의’에게 질문을 잘해서 원하는 답 얻어내기 (모델은 그대로 두고 입력만 조절)

- RAG: ‘일반의’에게 최신 의학 서적(외부 지식)을 찾아보게 한 후 답변하게 하기 (모델은 그대로 두고 외부 정보 활용)

파인튜닝은 모델 자체를 특정 작업에 더 적합하게 ‘변화’시킨다는 점에서 다른 접근법들과 근본적인 차이가 있습니다.

파인튜닝, 실제로 어떻게 활용될까요? 대표적인 적용 사례

파인튜닝은 다양한 AI 분야에서 모델 성능을 높이기 위해 활발히 활용되고 있습니다.

- 자연어 처리 (NLP):

- 감성 분석: 영화 리뷰, 상품평 등 텍스트의 긍정/부정을 분류하는 모델을 특정 도메인(예: 전자제품 리뷰) 데이터로 파인튜닝하여 정확도 향상.

- 질의응답 (Question Answering): 특정 문서나 지식 기반 내에서 질문에 답변하는 모델을 해당 문서 스타일이나 용어에 맞게 파인튜닝.

- 텍스트 분류: 뉴스 기사를 스포츠, 정치, 경제 등으로 분류하는 모델을 특정 매체의 기사 스타일이나 카테고리 체계에 맞게 파인튜닝.

- 맞춤형 챗봇: 특정 회사의 고객 지원 데이터나 내부 문서를 학습시켜, 회사 제품이나 서비스에 대해 더 정확하고 일관성 있는 답변을 제공하는 챗봇 개발.

- 컴퓨터 비전 (Computer Vision):

- 의료 영상 분석: ImageNet 등으로 사전 훈련된 이미지 분류 모델을 특정 질병(예: 암 진단) 관련 X-ray, CT, MRI 이미지 데이터로 파인튜닝하여 진단 보조 시스템 개발.

- 객체 탐지: 자율 주행 자동차를 위한 모델을 특정 도로 환경이나 날씨 조건의 이미지 데이터로 파인튜닝하여 보행자나 다른 차량 탐지 성능 개선.

- 위성 이미지 분석: 일반적인 위성 이미지 분석 모델을 특정 지역의 농작물 모니터링이나 재난 피해 분석용 이미지로 파인튜닝.

- 코드 생성:

- 특정 프로그래밍 스타일 적용: 범용 코드 생성 모델(예: GitHub Copilot)을 특정 회사의 코딩 스타일 가이드라인이나 내부 라이브러리 사용 패턴에 맞게 파인튜닝하여 일관성 있는 코드 생성.

파인튜닝의 빛과 그림자: 장점과 현실적인 고려사항

파인튜닝은 강력한 기법이지만, 장점과 함께 고려해야 할 단점들도 존재합니다.

| 장점 (Pros) | 단점 (Cons) / 고려사항 |

| 높은 성능: 특정 작업에서 매우 우수한 성능 달성 가능 | 데이터 요구: 특정 작업에 맞는 양질의 레이블된 데이터 필요 |

| 효율성: 처음부터 학습하는 것보다 시간, 비용 절약 | 재앙적 망각 (Catastrophic Forgetting): 새 작업 학습 시 기존 지식 잊어버릴 위험 |

| 데이터 효율성: 상대적으로 적은 데이터로도 효과 | 비용: 사전 훈련 모델 사용료, 추가 학습 위한 컴퓨팅 자원 비용 발생 |

| 거대 모델 활용: 최첨단 모델의 능력 활용 가능 | 기술적 복잡성: 적절한 모델 선택, 하이퍼파라미터 튜닝 등 전문 지식 필요 |

| 맞춤화: 특정 도메인/요구사항에 맞는 모델 구축 가능 | 과적합 (Overfitting): 소규모 데이터셋 사용 시 모델이 해당 데이터에만 과도하게 적합될 위험 |

특히 재앙적 망각은 파인튜닝 시 주의해야 할 중요한 문제입니다. 이를 완화하기 위해 점진적으로 학습시키거나, 특정 파라미터만 효율적으로 업데이트하는 PEFT(Parameter-Efficient Fine-Tuning) 기법들이 활발히 연구되고 있습니다.

파인튜닝의 현재와 미래: 진화하는 기법과 전망

파인튜닝 기술은 계속해서 발전하고 있습니다. 특히 거대 모델의 파인튜닝 비용과 복잡성을 줄이기 위한 노력이 활발합니다.

- PEFT (Parameter-Efficient Fine-Tuning): 모델의 전체 파라미터가 아닌, 아주 일부의 파라미터만 추가하거나 수정하여 파인튜닝하는 기법입니다. 훨씬 적은 자원으로 비슷한 성능을 달성할 수 있어 각광받고 있습니다.

- LoRA (Low-Rank Adaptation): 대표적인 PEFT 기법 중 하나로, 기존 가중치는 고정하고 저차원 행렬(Low-Rank Matrix)을 추가하여 학습하는 방식입니다.

- 어댑터 (Adapters): 사전 훈련 모델의 레이어 사이에 작은 신경망 모듈(어댑터)을 삽입하여, 이 어댑터만 학습시키는 방식입니다.

- 프롬프트 튜닝 (Prompt Tuning): 모델의 입력 부분에 학습 가능한 가상 토큰(Soft Prompt)을 추가하여, 이 프롬프트만 튜닝하는 방식입니다.

이러한 PEFT 기법들은 파인튜닝의 접근성을 높여, 더 많은 사람들이 특정 작업에 최적화된 고성능 AI 모델을 활용할 수 있도록 기여하고 있습니다. 앞으로 파인튜닝은 더욱 효율적이고, 다양한 데이터 형태(멀티모달)에 적용 가능하며, 개인화된 AI 경험을 제공하는 핵심 기술로 계속 발전할 것으로 전망됩니다.

파인튜닝, AI 모델의 잠재력을 깨우는 요소

파인튜닝은 이미 강력한 능력을 갖춘 사전 훈련 모델에 ‘화룡점정’을 찍어, 특정 작업에서의 잠재력을 최대한으로 끌어내는 핵심적인 기술입니다. 막대한 자원 없이도 고성능 AI 모델을 특정 목적에 맞게 최적화할 수 있다는 점에서, AI 기술의 민주화에도 크게 기여하고 있습니다.

마치 잘 만들어진 연장을 특정 작업에 맞게 날카롭게 갈고 닦는 것처럼, 파인튜닝을 통해 우리는 AI라는 도구를 더욱 정교하고 효과적으로 사용할 수 있습니다. 물론 데이터 준비, 재앙적 망각, 비용 등 고려해야 할 점들도 있지만, 그 효과는 매우 강력합니다.

여러분의 문제 해결에 범용 AI 모델의 성능이 조금 아쉬웠다면, 혹은 특정 분야에 대한 전문성을 AI에 부여하고 싶다면, 파인튜닝이라는 매력적인 선택지를 고려해 볼 가치가 충분합니다.

파인튜닝은 언제 사용하는 것이 가장 좋을까요?

특정 작업이나 특정 도메인에 대한 성능이 매우 중요하고, 해당 작업에 맞는 양질의 (비교적 소규모) 레이블된 데이터셋을 확보할 수 있을 때 파인튜닝을 고려하는 것이 좋습니다. 범용 모델의 성능이 이미 충분하거나, 관련 데이터 확보가 어려운 경우, 또는 빠른 프로토타이핑이 필요할 때는 프롬프트 엔지니어링이나 RAG가 더 적합할 수 있습니다.

파인튜닝을 위해 얼마나 많은 데이터가 필요한가요?

필요한 데이터 양은 작업의 복잡성, 사전 훈련 모델의 성능, 목표 성능 수준에 따라 크게 달라집니다. 일반적으로 사전 훈련 방식보다는 훨씬 적은 양이 필요하며, 수백 개에서 수천 개, 또는 수만 개의 데이터로도 의미 있는 성능 향상을 얻을 수 있는 경우가 많습니다. 중요한 것은 데이터의 ‘양’보다는 ‘질’과 ‘관련성’입니다.

파인튜닝에는 비용이 많이 드나요?

처음부터 모델을 학습시키는 것보다는 훨씬 저렴하지만, 여전히 비용이 발생합니다. 사전 훈련 모델 API 사용료(필요시), 추가 학습을 위한 클라우드 컴퓨팅 자원(GPU 등) 비용, 그리고 데이터 준비 및 레이블링 비용 등을 고려해야 합니다. PEFT 기법을 사용하면 컴퓨팅 비용을 상당히 절감할 수 있습니다.

파인튜닝 대신 사용할 수 있는 다른 방법은 무엇인가요?

앞서 비교표에서 설명했듯이, 프롬프트 엔지니어링은 모델 수정 없이 입력 조절만으로 성능을 개선하는 간편한 방법입니다. RAG(Retrieval-Augmented Generation) 는 외부 지식 검색을 통해 최신 정보나 특정 문서 기반 답변 능력을 향상시키는 데 효과적입니다. 작업의 특성과 요구사항, 가용 자원 등을 고려하여 가장 적합한 방법을 선택해야 합니다.