Last Updated on 2025-08-08 by AEIAI.NET

인공지능 진화 속도, 2025년 기술 판도가 뒤집히다

2025년 5월 현재, 인공지능(AI) 분야의 발전 속도는 상상을 초월하며, 그 변화는 표면적 개선을 넘어 핵심 기술 스택 전반을 아우르고 있습니다. 모델 설계부터 실제 작동 방식, 인프라, 서비스까지, AI 생태계 전체가 새로운 형태로 재편되고 있죠. 마치 여러 갈래의 급류가 한데 합쳐져 거대한 파도를 만들어내듯, 동시 다발적인 혁신이 예측 불가능한 변동성을 만들어내고 있습니다.

단일 중앙 시스템의 한계를 극복하는 분산형 학습 기법의 등장, 인간의 복잡한 지시를 스스로 해석하고 완수하는 자율 에이전트의 현실화, 그리고 이 모든 기술 발전을 뒷받침하는 하드웨어 및 인프라 거인의 혁신, 거대 기술 기업들의 AI 전략 대전환까지. 지금 우리는 AI가 만들어내는 격변의 중심에 서 있습니다. 이러한 변화의 물결 속에서 2025년 인공지능 기술의 동향이 뭐고, 앞으로 우리는 어떤 점에 주목해야 할지, AI 시장에서 일어나고 있는 최신 트렌드를 살펴보겠습니다.

AI 학습의 새롭게 대두되는 방식 : 중앙이 아닌 분산형 기술

분산형 시스템 분야 전문가들의 기대를 한 몸에 받고 있는 기술이 있습니다. 바로 프라임 인텔렉트(Prime Intellect) 팀이 선보인 인델렉트 2(Indelect 2) 모델인데요. 이 모델은 약 320억 개의 매개변수를 가진 추론 모델이지만, 그 학습 방식이 기존 거대 AI 모델과 완전히 차별화됩니다. 통상적으로 거대 AI 모델은 엔비디아(Nvidia) 같은 회사의 강력한 GPU가 밀집된 대규모 데이터 센터에서 모든 자원이 엄격하게 동기화된 상태로 학습됩니다. 하지만 인델렉트 2는 이러한 중앙 집중식, 동기식 접근 방식에서 벗어나, 전 세계에 흩어진 비허가 참여자들의 협력적인 ‘스웜(swarm)’을 통해 비동기적으로 학습을 진행한다는 특징을 가집니다.

프라임 인텔렉트는 ‘all-to-all gradient party’로 불리는 기존의 동기식 학습 방식을 대체하기 위해 프라임 RL(Prime RL)이라는 자체 개발 비동기 프레임워크를 사용합니다. 이 프레임워크는 학습 과정을 세 단계로 효율적으로 분할합니다. 첫째, ‘롤아웃 생성(Rollout generation)’은 추론 워커들이 실제 또는 시뮬레이션 환경에서 모델의 작동 궤적(trajectories) 데이터를 만드는 과정입니다. 둘째, ‘모델 학습(model training)’은 학습 노드들이 이 롤아웃 데이터를 바탕으로 경사(gradients)를 계산하고 모델 매개변수를 업데이트하는 단계입니다. 셋째, ‘가중치 전파(weight broadcasting)’는 샤드캐스트(ShardCast)라는 트리 구조의 HTTP 네트워크를 통해 업데이트된 모델 가중치를 신속하게 공유하는 과정입니다. 이러한 비동기 방식 덕분에 특정 노드의 속도가 느려지더라도 전체 학습 프로세스가 지연되는 병목 현상을 최소화할 수 있습니다. 이는 마치 각자 맡은 부분을 독립적으로 처리하되 결과물은 빠르게 공유하여 전체 진행 속도를 유지하는 분산 작업 환경과 유사합니다.

물론 분산 시스템에서는 악의적인 참여자(bad actors)가 잘못된 데이터나 결과를 주입할 위험이 존재합니다. 프라임 인텔렉트는 이러한 문제를 해결하기 위해 탑 락(Top Lock)이라는 독창적인 메커니즘을 고안했습니다. 탑 락은 지역 민감 해싱(locality sensitive hashing) 기술을 활용하여 조작되거나 품질이 낮은 결과물을 효과적으로 탐지하고, 부정행위를 시도한 참여자에게 온체인(onchain) 방식으로 페널티를 부과함으로써 시스템의 신뢰성을 확보합니다. 학습 자체의 안정성을 위해서는 고전적인 GRPO 알고리즘에 양방향 토큰 확률 비율 클리핑(two-sided token probability ratio clipping)을 추가하여 경사 폭발을 방지하고, 공격적인 경사 노름 클리핑(aggressive norm clipping)을 적용하여 320억 개의 매개변수 업데이트 과정에서 발생할 수 있는 미세한 불안정성까지 억제하는 기술적 정교함을 보였습니다.

인델렉트 2는 누미나 매스 1.5(Numina Math 1.5), 딥 스케일러(deep scaler), 그리고 자체 생성 합성 데이터셋을 포함한 총 28.5만 개의 수학 및 코딩 관련 작업 데이터로 학습되었습니다. 보상 체계는 작업의 성공 여부에 따른 이진 신호와 함께, 나중에 추론 시 필요한 ‘사고 토큰(thinking tokens)’ 예산을 아낄 수 있도록 유도하는 길이 페널티(length penalty)로 구성됩니다. 정책 전파(policy broadcast)와 새로운 롤아웃 생성이 동시에 진행되는 2단계 비동기 방식 덕분에 통신 지연이 전체 성능에 미치는 영향이 미미하다는 점도 특징입니다. 연구팀은 효율적인 추론기 개발에 초점을 맞춘 ‘타겟 쇼트(Target short)’와 더 큰 컨텍스트 창 활용 능력을 목표로 한 ‘타겟 롱(Target long)’ 실험을 진행했습니다.

벤치마크 테스트 결과, 인델렉트 2는 수학 및 코딩 작업에서 QWQ32B 모델 대비 약간의 성능 우위를 보였지만, 학습 분포에서 벗어난 영역에서는 성능 향상이 둔화되는 한계점도 드러냈습니다. 연구팀은 향후 퀸 3(Quinn 3)와 같이 더욱 강력한 기반 모델이나 질적으로 풍부한 작업 데이터의 필요성을 언급했습니다. 로드맵에는 추론 대비 학습 연산량 비율 증대, 웹 검색이나 파이썬 실행 등 외부 도구 사용(tool calls) 기능 통합, 크라우드소싱 기반 강화 학습 환경 개선, 그리고 DLOCO를 활용한 분산 학습 모델 병합 시도 등이 포함됩니다. 인델렉트 2와 관련 기술 스택은 모두 오픈 소스로 공개되어 있어, 누구나 분산된 컴퓨팅 자원을 활용하여 거대 모델 학습에 기여할 수 있는 새로운 가능성을 열었다는 점에서 그 의미가 큽니다.

시키는 일 넘어 목표 완성, 자율 에이전트의 약진

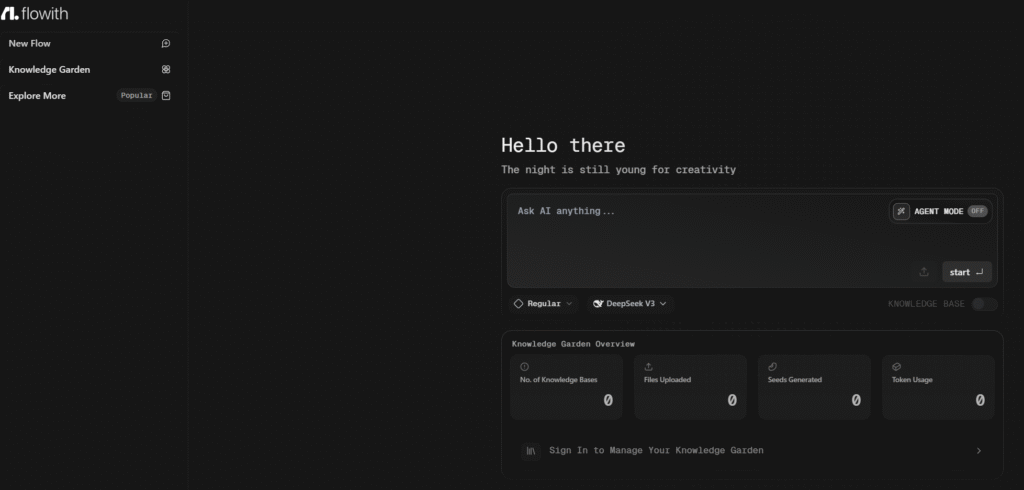

모델 학습 방식이 분산화되는 변화와 동시에, 학습된 모델을 활용하여 스스로 복잡한 과제를 처리하는 AI 에이전트들도 눈에 띄게 발전하고 있습니다. 특히 플로우위드(Flowith) 같은 플랫폼에서 구현되는 AI 에이전트들은 단순 질의응답 수준을 넘어, 스스로 계획을 세우고 실행하며 최종 목표를 달성하는 ‘자율 에이전트’ 개념을 현실로 만들고 있습니다. 시각적인 캔버스 인터페이스를 통해, 사용자는 에이전트가 문제 해결 과정을 어떻게 ‘생각’하고 ‘계획’하는지 실시간으로 확인하고 필요에 따라 개입할 수 있습니다. 이는 마치 AI의 사고 과정을 눈으로 보며 협업하는 경험과 같습니다.

플로우위드의 최신 네오(Neo) 에이전트는 이러한 자율성을 극대화했다는 평가를 받습니다. 클라우드 환경에서 상시 대기하며 천 개 이상의 단계를 소화하고, 확장된 컨텍스트 메모리 덕분에 이전 대화나 작업 이력을 모두 기억하여 일관성 있는 작업 수행이 가능합니다. 또한, 웹사이트 전체, 연구 논문 초안, 자동화된 이메일 시퀀스 등 복잡하고 방대한 형태의 결과물을 스스로 생성해낼 수 있습니다. 이는 기존의 AI 도구와 달리, 마치 독립적인 팀원처럼 느껴지는 수준의 자율성을 보여줍니다.

이미 플로우위드 에이전트는 실제 다양한 프로젝트에서 성과를 내고 있습니다. 실시간 주식 정보 대시보드 구축부터 매일 업데이트되는 소셜 미디어 콘텐츠 파이프라인 자동화, 인터랙티브 3D 탱크 전투 게임 개발, AI 생성 제품 랜딩 페이지 제작, 교육용 시뮬레이터 구현까지 그 활용 범위는 넓습니다. 특히 흥미로운 사례는 3D 풀 게임 개발입니다. 단순히 정적인 이미지가 아닌, 사실적인 그래픽, 부드러운 애니메이션, 정확한 물리 엔진이 적용된 인터랙티브 게임이 코드 한 줄 작성 없이 AI 에이전트의 작업만으로 완성되었다는 점은 주목할 만합니다. 이는 매니스(Manis)나 러버블(Lovable) 같은 다른 에이전트들이 유사한 작업에서 난항을 겪었던 것과 비교됩니다.

네오 에이전트의 또 다른 강점은 필요에 따라 ‘하위 에이전트’를 생성하여 마치 팀을 꾸려 업무를 분담하듯 여러 작업을 병렬로 처리하게 할 수 있다는 것입니다. 특정 조건 충족 시 작업을 자동으로 예약하거나 실행하도록 트리거를 설정하고, 백그라운드에서 반복 수행되는 워크플로우를 구축하는 것도 가능합니다. 모바일 기기에서도 작업 진행 상황을 확인하고 기본적인 제어를 할 수 있어 언제 어디서든 AI 자원을 활용한 작업 관리가 용이합니다. 이러한 기술은 이미 전체 애플리케이션 개발, 창의적 콘텐츠 생성 자동화, 복잡한 마케팅 캠페인 설계 등에 적용되고 있으며, 이 모든 과정에서 사용자가 코딩 지식 없이도 전문가 수준의 결과물을 만들 수 있다는 점이 핵심입니다. 이는 AI가 단순 보조 도구를 넘어 창작과 업무 자동화의 강력한 주체로 발전하고 있음을 명확히 보여줍니다.

엔비디아의 AI 영토 확장: 인프라에서 로봇까지

오픈 소스 커뮤니티가 AI 모델 학습 방식의 민주화를 시도하는 동안, 대만 컴퓨텍스(Computex)에서는 엔비디아의 젠슨 황(Jensen Huang) CEO가 AI 하드웨어 및 인프라 시장에서의 독보적인 입지를 다시 한번 확인시켰습니다. 그는 2025년 현재, AI 기술 발전의 가장 큰 병목은 ‘컴퓨팅 자원에 쉽고 빠르게 접근하는 것(friction-free access to compute)’이라고 진단하며, 이를 해결하기 위한 엔비디아의 구체적인 전략들을 발표했습니다.

첫 번째 핵심 전략은 DGX 클라우드 렙틴(DGX Cloud Leptin)입니다. 이는 엔비디아 AI GPU 자원의 마켓플레이스로, 코어위브(Coreweave), 소프트뱅크(SoftBank), 크루소(Crusoe), 람다(Lambda), 폭스콘(Foxconn), 야타(Yotta) 등 다양한 클라우드 및 지역 공급자들이 보유한 여유 자원을 한데 묶어 거대한 AI 컴퓨팅 풀을 만듭니다. 사용자는 필요한 자원과 기간을 선택하기만 하면, 렙틴이 복잡한 계약 절차나 자원 풀링, 스케줄링 문제를 자동으로 처리하여 GPU 할당 대기 시간을 최소화합니다. 젠슨 황은 이를 통해 개발자는 연구 개발에 집중하고, 공급자는 자원 활용률을 극대화하며, 수동적인 자원 배치 및 관리의 번거로움을 없앨 수 있다고 설명했습니다. 이는 AI 개발에 필수적인 컴퓨팅 파워 접근성을 혁신적으로 개선하는 시도입니다.

두 번째 주요 발표는 NV링크 퓨전(NVLink Fusion)입니다. 이 기술은 클라우드 인프라 구축 기업들이 엔비디아의 표준 랙 스케일 패브릭(rack-scale fabric)에 특정 애플리케이션 가속기나 퀄컴(Qualcomm)의 AI 튜닝 오리온(Orion) 부품, 후지쯔(Fujitsu)의 ARM 프로세서와 같은 타사 CPU까지도 유연하게 연결할 수 있도록 지원하는 설계 키트입니다. 800Gbit의 통신 속도와 GPU 메모리 일관성을 유지하면서도 훨씬 다양한 형태의 토폴로지 구성이 가능해져 데이터센터 확장의 유연성과 커스텀 최적화 역량을 크게 높입니다. 미디어텍(MediaTek), 마벨(Marvell), 알립(Alip), 케이던스(Cadence), 아스테라 랩스(Astera Labs) 등 다수의 기업이 이미 퓨전 기반 맞춤형 칩 개발 파트너로 참여하며, 엔비디아가 꿈꾸는 ‘수백만 개의 GPU가 유기적으로 연결된 거대 컴퓨팅 환경’ 구축을 현실화하겠다는 의지를 보여줍니다.

휴머노이드 로봇 분야 역시 엔비디아의 중요한 관심 영역입니다. 컴퓨텍스에서 곧 출시될 젯슨 토르(Jetson Thor) 보드에 탑재될 이족보행 로봇용 파운데이션 모델인 아이작 그루트 N1.5(Isaac Groot N1.5)가 공개되었습니다. 특히 단 한 장의 이미지만으로 로봇 훈련용 비디오를 생성하는 그루트 드림즈(Groot Dreams) 도구는 주목받았습니다. 이를 통해 로봇은 부품 집기, 상자 분류 같은 복잡한 작업을 실제 물리적 세계가 아닌 가상 시뮬레이션 환경에서 미리 학습하며 효율을 높일 수 있습니다. 그루트 미믹(Groot Mimic)은 소수의 인간 데모만으로 방대한 움직임 데이터셋을 자동 생성하여, 옴니버스(Omniverse) 기반의 데이터 플라이휠을 가속화합니다.

옴니버스 활용의 실질적인 사례로 페가트론(Pegatron)과의 협력 내용이 소개되었습니다. 350억 달러 규모의 주요 ODM 기업인 페가트론은 자사의 PEG버스(PEGverse) 디지털 트윈 시스템이 새로운 공장 건설 시간을 40% 단축했으며, 엔비디아 VSSS 청사진으로 훈련된 비전 AI 에이전트가 조립 라인 불량률을 2/3 감소시켰다고 발표했습니다. 이는 AI 기술이 단순한 아이디어를 넘어 실제 산업 현장에서 측정 가능한 투자 회수(ROI)를 제공하고 있음을 보여주는 중요한 사례입니다.

전통적인 GPU 시장에서는 차세대 GB300 시스템이 3분기 출시 예정이며, 이미 설치된 하이퍼스케일러들의 그레이스 블랙웰(Grace Blackwell) 시스템 업그레이드가 기대됩니다. 하지만 즉각적인 시장 반응을 얻은 것은 RTX 프로(RTX Pro) 서버였습니다. 이 서버는 H100 대비 딥시크(Deepseek) 학습 속도를 4배, 메탈 라마(Metal Lama) 학습 속도를 1.7배 향상시키면서도 현재 즉시 구매 가능하다는 강점이 있습니다. 급증하는 AI 수요와 GPU 공급 부족 상황에서 몇 달씩 GPU를 기다리기 어려운 스타트업들에게 DGX 클라우드 렙틴과 RTX 프로 조합은 가뭄의 단비 같은 현실적 해결책이 될 수 있습니다.

| 기술/서비스 | 주요 특징 | 잠재적 효과 | 난이도/비용 (상대적) | 주의사항 |

|---|---|---|---|---|

| DGX Cloud Leptin | 전 세계 GPU 자원 통합/중개 플랫폼 | 컴퓨팅 자원 접근성 및 활용 효율 증대 | 사용자: 낮음 공급자: 높음 | 자원 공급자별 가용성 및 가격 변동 가능성 |

| NVLink Fusion | 타사 HW 통합 가능한 패브릭 설계 표준 | 데이터센터 확장 유연성 및 커스텀 최적화 향상 | 구축사: 높음 | 다양한 HW 간의 호환성 및 통합 과정 복잡성 |

| Isaac Groot N1.5 | 휴머노이드 로봇용 AI 파운데이션 모델 | 로봇 학습 및 자율 행동 능력 향상 | 높음 | 로봇 하드웨어 연동 및 대규모 훈련 데이터 구축 필요 |

| RTX Pro 서버 | 고성능 AI 학습/추론용 서버 (H100 대비 성능 향상) | AI 개발 워크로드 가속화, 즉시 도입 가능성 | 중간-높음 | 초기 도입 비용, 특정 작업에서의 성능 편차 가능성 |

| 분산형 AI 학습 | P2P/비동기 방식 모델 학습 | 학습 비용 절감 가능성, 탈중앙화 시스템 구축 | 높음 | 시스템 설계 복잡성, 악의적 참여자 방지 등 보안 문제, 학습 안정성 확보 |

| 자율 에이전트 | 자체 계획/실행 복합 작업 자동화 | 생산성 혁신, 전문성 없이도 복잡 작업 수행 가능성 | 플랫폼마다 상이 | 초기 목표 설정의 명확성 필요, 예상치 못한 결과 발생 가능성 |

빅테크의 AI 생존 전략: 애플과 유튜브의 변신

인공지능 기술의 급류 속에서 거대 기술 기업들 역시 미래 생존을 위한 대대적인 AI 전략 재편에 나서고 있습니다. 블룸버그(Bloomberg)의 마크 거먼(Mark Gurman) 기자의 보도에 따르면, 애플(Apple)은 기존의 시리(Siri)를 땜질식으로 개선하는 방식으로는 더 이상 경쟁력이 없음을 인정했습니다. 애플 내부에서는 챗GPT(ChatGPT)가 등장하여 폭발적인 반응을 얻은 2022년 말 이후에야 자체적인 생성형 AI, 일명 ‘애플 인텔리전스(Apple intelligence)’ 개발이 본격화되었다고 합니다. 이는 당시 AI 총괄 책임자가 휴대폰에서의 챗봇 수요를 과소평가하여 GPU 투자에 소극적이었고, 기존 규칙 기반 시리에 그럴듯한 기능만 덧붙이려 했던 과거 전략의 실패를 인정한 셈입니다. 내부 엔지니어들은 이러한 노력을 버그 하나를 고치면 새로운 문제가 세 개씩 생겨나는 ‘두더지 잡기’에 비유하기도 했습니다. 결국 불완전한 인텔리전스 기능 출시와 그로 인한 소송까지 겪으며, 애플은 AI 전략을 전면 ‘재설정’하고 시리를 처음부터 LLM(거대 언어 모델) 기반으로 재구축하는 작업에 착수했습니다.

새로운 시리의 핵심 목표는 진정한 의미의 대화형 AI 비서가 되는 것입니다. 여러 정보 출처를 종합하고, 퍼플렉시티(Perplexity)처럼 웹을 자유롭게 탐색하여 데이터를 가져오는 능력을 갖추는 것을 목표로 합니다. 과거처럼 울프램 알파(Wolfram Alpha)나 옐프(Yelp)와 같은 특정 서비스의 단편적인 정보에만 의존하는 것을 넘어, 다양한 소스의 정보를 능숙하게 다루는 AI를 만들겠다는 포부입니다. 시리 규모에서 완전한 온디바이스(on-device) LLM 구현은 아직 기술적으로 어렵기 때문에, 애플은 GPU 팜 구축에 막대한 투자를 진행하고 있습니다. 새로운 스택은 온디바이스에서의 즉각적인 요약 기능과 클라우드를 활용한 복잡한 추론 기능을 결합한 하이브리드 형태가 될 것으로 예상됩니다. 거먼의 소식통들은 다음 아이폰 출시 주기까지 새로운 시리의 핵심 기능을 선보이기를 바라지만, 개발 일정이 매우 촉박하다고 전합니다. 만약 애플이 이를 성공적으로 해낸다면, “애플은 AI 웨이브를 놓쳤다”는 기존의 회의적인 시각을 뒤집고 “모두가 클라우드 기반 AI에 집중할 때 애플은 강력한 개인정보 보호를 갖춘 온디바이스 AI를 구현했다”는 새로운 서사를 만들 수 있습니다. 어떤 결과가 나오든, 대중적인 AI 경쟁에서 뒤처졌다는 평가를 받은 후 애플에게 AI 기술력 확보는 기업의 미래 경쟁력과 직결된 필수 과제가 되었습니다.

한편, 유튜브(YouTube)는 영상 중간 광고 삽입 방식을 넘어 더욱 정교한 광고 전략을 모색하고 있습니다. 제미나이(Gemini) 기반의 ‘피크 포인트(Peak Points)’라는 새로운 시스템을 테스트 중인데, 이 기술은 제미나이가 영상의 모든 프레임과 대본을 분석하여 시청자의 몰입도나 감정적 반응이 최고조에 달하는 순간(예: 드라마틱한 반전, 예상치 못한 성공 장면 등)을 포착하고, 그 절정 바로 직후에 광고를 노출하는 방식입니다. 뉴욕의 ‘브랜드캐스트(Brandcast)’ 행사에서 유튜브는 결혼 프로포즈 영상으로 이를 시연했습니다. 반지를 끼워주고 환호성이 터져 나오는 감동적인 순간 직후 영상이 끝나고 광고가 재생되었습니다. 이는 시청 경험을 최소한 클라이맥스에서 끊지 않으면서도 광고 효과를 극대화하려는 시도입니다. 본질적으로 시청자의 감정 반응 데이터를 기반으로 광고 노출 시점을 결정하는 ‘감정 기반 타겟팅’의 한 형태로 볼 수 있습니다. 시청자의 도파민 수치가 높고 내용 회상률이 가장 높을 것으로 예상되는 순간에 광고를 노출함으로써 브랜드 메시지의 각인 효과를 높이겠다는 전략입니다. 유튜브 측은 되감기나 시청 완료율 같은 다른 시청 데이터를 함께 활용하는지는 구체적으로 밝히지 않았지만, 파일럿 테스트 결과 프레임 및 대본 분석만으로도 충분한 효과를 보였다고 합니다. 광고주 입장에서는 광고가 시청자에게 가장 잘 받아들여질 가능성이 높은 시점에 노출된다는 장점이 있고, 크리에이터는 수동으로 광고 삽입 시점을 지정할 필요 없이 수익 증대를 기대할 수 있습니다. 시청자들의 초기 반응은 다양합니다. 일부는 콘텐츠 흐름이 자연스러워져 덜 방해받는다고 느끼는 반면, 다른 일부는 AI가 자신의 감정을 분석하여 광고에 활용한다는 사실에 불편함이나 거부감을 표하기도 합니다. 이 기능은 현재 일부에서 파일럿 테스트 중이며, 올해 말 더 많은 지역으로 확대될 예정입니다. 만약 효과와 사용자 수용성이 입증된다면, 피크 포인트는 온라인 비디오 광고의 새로운 표준이 될 가능성이 높으며 다른 플랫폼들도 유사한 방식을 도입할 수 있습니다.

2025년, AI가 만들어갈 청사진은…

현재 인공지능 기술은 특정 분야의 개선을 넘어, 생태계의 근본적인 변화를 이끌고 있습니다. 분산 학습을 통한 모델 학습 방식의 민주화 시도, 목표 지향적 작업을 스스로 완수하는 자율 에이전트의 발전, 그리고 이 모든 기술의 토대가 되는 컴퓨팅 인프라의 혁신, 거대 기술 기업들의 AI 전략 재편까지. 우리는 지금 AI 역사의 새로운 장이 열리는 순간을 목격하고 있습니다.

이러한 변화의 속도는 가늠하기 힘든 수준이며, 각 기술 영역의 발전은 서로 시너지를 일으키며 AI 생태계를 더욱 복잡하고 강력하게 만들고 있습니다. 분산형 학습은 더 광범위한 자원을 활용하여 거대 모델을 구축하는 기반을 제공하고, 자율형 에이전트는 그 모델을 현실 세계의 다양한 문제 해결에 적용하며, 엔비디아와 같은 기업들은 이러한 모든 활동을 지원하는 물리적, 가상적 인프라를 끊임없이 혁신하고 있습니다. 애플과 유튜브 같은 거대 플랫폼의 AI 전략 변화는 이러한 기술 발전이 단순 기술 영역에 머무르지 않고 우리의 일상생활, 업무 방식, 미디어 소비 행태에 깊숙이 파고들 것임을 예고합니다. 앞으로 인공지능이 우리의 미래에 어떤 변화를 가져올지, 그리고 우리는 이 변화에 어떻게 적응하고 대비해야 할지 계속해서 주의 깊게 살펴볼 필요가 있습니다. 이제 AI가 삶의 모든 영역에서 영향을 미치고 변화를 줄 것임은 피할 수 없어 보입니다.

분산형 AI 학습은 단일 중앙 서버에 대한 의존도를 줄여 시스템의 병목 현상과 단일 실패 지점 위험을 완화합니다. 또한, 전 세계에 분산된 다양한 컴퓨팅 자원을 활용함으로써 더 큰 규모의 모델 학습을 가능하게 하고, 특정 기업의 하드웨어 독점에 대한 의존도를 낮추는 잠재적인 장점이 있습니다.

기존 AI 비서나 챗봇은 사용자의 명확한 지시나 질문에 대해 정해진 범위 내에서 반응하는 수동적인 역할에 머무는 경우가 많습니다. 반면 자율 에이전트는 사용자가 제시한 높은 수준의 목표를 스스로 해석하여 필요한 하위 작업을 계획하고, 여러 단계를 거쳐 실행하며, 예상치 못한 상황에 대응하는 등 복잡한 과제를 능동적으로 해결해 나간다는 점에서 근본적인 차이가 있습니다.

이 기술들은 AI 개발에 필수적인 고성능 컴퓨팅 자원에 접근하는 과정을 훨씬 간소화하고 유연하게 만듭니다. 개발자들은 복잡한 인프라 관리나 GPU 확보 문제에 덜 신경 쓰고 AI 모델 개발 자체에 집중할 수 있게 되며, 다양한 하드웨어를 통합하거나 맞춤형 시스템을 구축하는 것이 용이해져 연구 개발 및 상용화 속도를 높일 수 있습니다.

애플은 현재 기존 시리를 LLM 기반으로 재구축하는 대규모 프로젝트를 진행 중입니다. 보도에 따르면 다음 아이폰 출시 시점(통상 가을)에 맞춰 일부 개선된 기능을 선보이는 것을 목표로 하고 있지만, 완전하게 재탄생한 시리의 모든 기능을 경험하기까지는 다소 시간이 걸릴 수 있습니다.

피크 포인트는 AI가 영상 분석을 통해 시청자의 몰입도가 높은 순간을 파악하여 광고를 배치함으로써, 기존 방식보다 시청 경험을 덜 방해할 수 있습니다. 일부 시청자는 광고가 더 자연스럽게 느껴질 수 있지만, AI가 자신의 감정 반응을 광고에 활용한다는 점에 대해 사생활 침해나 조작으로 느낄 수도 있습니다. 이는 시청자의 성향에 따라 다르게 받아들여질 수 있으며, 현재 파일럿 테스트를 통해 사용자 반응을 살피는 단계입니다.